L'année 2009 du web

En 2008, Google à modifié la donne en instaurant un contrôle très fin du duplicate content ce qui a provoqué la fin de nombreux annuaires et sites fait de flux RSS.

En 2009 les principaux moteurs on résolu le problème du duplicate content sur un même site en créant la balise canonical. Et 2009 voit le développement des services offerts par Google. C'est le cas de Earth qui permet de visiter le fond des océans et de Maps qui localise les téléphones portables.

Le moteur de recherche connaît des changements pour fournir des résultats de plus en plus pertinents et les webmasters ont révisé leur méthodes habituelles d'optimisation.

Encarta c'est fini

Qui a causé la mort d'Encarta, l'encyclopédie sur CD-Rom de Microsoft qui s'est vendue à des millions d'exemplaires? Wikipedia? Non, c'est le moteur de recherche Google!

On doit se rendre à l'évidence chez Microsoft: On ne recherche plus l'information comme avant, en ouvrant une encyclopédie, dorénavant on la recherche sur le Web et la recherche sur images permet de compléter les articles sans limites.

A coté du moteur de recherche, les outils comme Maps et Earth (ou Virtual Earth pour Microsoft) fournissent une source de connaissance géographique face auxquelles des documents statiques paraissent bien misérables.

Encarta a été lancée en 1993 au même prix que les autres encyclopédies sur CD, pour 395 dollars. C'était un support multimédia avec un atlas, 11 000 photos et du son digitalisé.

Elle était alors en concurrence avec Britanica, et le leader du domaine était Compton's Interactive Encylopédia. Mais Encarta ne parvient à capter que 3% du marché.

Pire encore, Compton's décide de baisser le prix à 129$. Microsoft est obligé de suivre et Encarta passe à 99$. Les ventes progressent alors et atteignent le million d'exemplaires en 1994.

Une version limitée gratuite est introduite en 2000 tandis que le prix ne cesse de baisser pour tomber à 23 dollars en 2009.

La commercialisation cessera cette année et le site Encarta va également fermer.

Geocities, c'est fini

Un nouveau pilier du Web vient de s'effondrer sous l'effet de la crise économique, combiné avec les tractations pour conclure un rapprochement entre Yahoo et Microsoft.

Yahoo annonce la fin des inscriptions et la clôture définitive du service d'hébergement gratuit dans le courant de l'année.

Le site affichait le message suivant:

Sorry, new GeoCities accounts are no longer available.

Geocities, fondée en 1994 sous forme de site social, avait été rachetée par Yahoo en 1999 pour 4,7 milliards de dollars!

Mais le site était en déclin, passant de 15 millions de visiteurs en mars 2008 à 11 millions en mars 2009.

La fin de geocities si elle témoigne d'un changement d'époque, ne laisse pas les webmasters sans ressources pour autant.

Les blogueurs disposent de nombreuses offres d'hébergement gratuit tels que Wordpress.com, Blogger.com.

Il existe d'autres formes d'hébergements gratuits indiqués sur notre comparatif des hébergeurs.

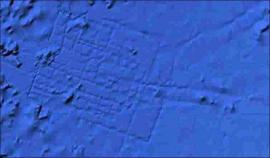

Google Earth a-t-il trouvé l'Atlantide?

La dernière version de Earth qui permet d'explorer le fond des océans aurait permis une découverte extraordinaire.

Un ingénieur de l'aérospatiale britanique a pu observer les traces d'une citée engloutie au large des îles Canaries (31 15'15.53N, 24 15'30.53W) que l'on discerne sur l'image à droite.

Les experts de la légende de l'Atlantide estiment que les coordonnées correspondent à une des localisation possibles de la cité selon les écrits du philosophe grec de l'antiquité Platon.

Mais Google donne une explication totalement différente:

Dans ce cas, ce que voient les utilisateurs est un artefact dû au processus de collecte des données.

Les données sont acquise avec des sonar et les lignes reflètent le chemin qui suivent les bateaux. Les zones blanches montrent qu'on en sait peu sur le monde des océans."

Les amateurs de mythes et légendes seront déçus. Cependant, Earth a permis de faire d'autres découvertes étonnantes, comme une forêt primitive au Mozambique avec une faune inconnue, et n'a pas fini de nous surprendre.

Google signale le Web tout entier comme une menace

Le 31 janvier s'annonçait comme un jour sombre pour le Web, Google plaçant dans ses résultats un message d'avertissement sur absolument toutes les pages:

"Attention! Ce site peut nuire à votre ordinateur."

Ce qui n'était pas sans inquiéter les webmasters. Les messages seraient restés présents entre 18h30 et 19h25. Google vient de s'expliquer sur ce qui s'est passé exactement.

Google maintient une liste de sites qui sont susceptibles de représenter une menace, parcequ'ils hébergent un script contenant des virus, des chevaux de troie ou autre malware. Quelquefois même à l'insu du webmaster.

En fait Google s'en remet à un site indépendant, Stopbadware.org, géré par une association sans but lucratif, pour définir les critères pour classer un site comme nuisible. Elle indique aussi aux webmasters ce qu'il faut faire pour que leur site soit retiré de la liste.

C'est après la dernière mise à jour de la liste qu'est survenue l'erreur qui à mis le Web tout entier à l'index. Le symbole "/" a été pris comme nom de fichier et cela s'est appliqué à toutes les URL contenant ce symbole...

Comme le message d'avertissement renvoie sur le site StopBadware, les serveurs de celui-ci ont été saturés.

Oracle rachète Sun: Implications

Le rachat de Sun (Java, MySQL, Solaris, Open Office) par Oracle (base de données) suscite des réactions plutôt négatives sur les forums. Quelles sont les implications pour les utilisateurs et les Webmasters de cette acquisition?

- Solaris

Le système d'exploitation Solaris est celui qui est le plus souvent utilisé pour faire fonctionner une base de données Oracle. Devenant possesseur de ce système open source, Oracle à moins de raisons de s'impliquer dans Linux, c'est donc une mauvaise nouvelle pour Linux. - Java

Java est aussi open source, et une version GNU existe pour la bibliothèque de fonctions.

L'acquisition ne devrait pas changer grand-chose pour le langage, mais NetBeans, l'excellent outil de développement entre en concurrence avec JDevelopper de Oracle qui est par ailleurs membre de la fondation Eclipse. Donc mauvaise nouvelle pour NetBeans. - MySQL

La base de donnée MySQL entre en concurrence avec la version légère de Oracle, Oracle Express. Il n'est donc pas dans l'intérêt du nouveau propriétaire de la développer.

Mais même si Sun possède le nom de marque, on ne sait ce qu'il possède concrètement avec MySQL, en effet la base de donnée est open-source et il existe plusieurs versions maintenues par des groupes de développeurs indépendants, quelque fois plus élaborées que la version de Sun.

MySQL est aussi en concurrence avec un autre logiciel libre, PostGreSQL plus performant. - Open Office

En achetant Sun, Oracle devient propriétaire de Star Office, la version commerciale, plutôt que de Open Office, la version open source gratuite. Open office était en fait principalement maintenue par les développeurs de Sun.

On ne sait quelles sont les intentions d'Oracle vis à vis d'Open Office. L'esprit de la compagnie la porterait plutôt à developper Star Office pour concurrencer Microsoft.

La fin du domain tasting

Dans cette jungle sauvage qu'est le Web, de bonnes choses arrivent de temps en temps malgré tout.

Le domain tasting est une pratique de spam qui tire profit de la période de 5 jours (Add grace period) accordée aux registrars avant de renoncer à l'acquisition d'un nom de domaine.

Cette facilité destinée à leur éviter des frais en cas d'erreurs, était détournée par des profiteurs qui pouvaient sans frais réserver un nom de domaine, le diriger sur un page publicitaire et l'abandonner au bout de 5 jours, et recommencer ainsi à l'infini, sans avoir à l'acheter vraiment.

Une opération qui devient profitable quand elle est réalisée en masse. Pour les registries, c'étaient des coûts de gestion inutiles et cela concernait des quantités d'opérations comme on le voit dans les statistiques.

Alors, durant un an, l'ICANN a décidé de prélever 0,20 dollars à partir d'un certain nombre d'opérations de résiliation. Puis depuis juillet 2009, les frais ont été fixés à 6,75 dollars. Résultat: disparition totale du domain tasting...

- 17 668 750 résiliations en juin 2008.

- 2 785 605 en juillet 2008.

- 58 218 en juillet 2009.

Le nombre restant correspond à des corrections d'erreurs de la part des registrars.

On rêve d'une mesure similaire au sujet des spams sous forme d'emails. Yahoo à lancé dans cette optique le projet Centmail: une taxe de 1 cent de dollar serait versée pour chaque email envoyé.

Le rapport de l'ICANN.

Les domaines en .be vont coûter très cher

L'organisme qui est chargé de la gestion des noms de domaines en .be vient de prendre des mesures draconniennes contre les cybersquatteurs.

On peut penser que l'enregistrempent d'un domaine en .be va devenir plus rare en sachant que 1620 euros seront dûs par le registrant si jamais on lui conteste le droit de posséder le nom de domaine et que la procédure aboutit avec succès pour le demandeur!

Rappelons que jusqu'ici, le coût d'une procédure et c'est le cas du .fr est à la charge de celui qui conteste l'utilisation d'un domaine et demande à ce qu'il lui soit transféré, quelle que soit la décision.

Cette mesure de DNS BE semble inquiétante car si quelques fois le cybersquatting (ou cybersquattage) apparaît de façon évidente (si par exemple un particulier déposait ibm.be ou microsoft.be), il peut arriver qu'il soit bien plus difficile de trancher et donc que l'enregistrement soit une opération à risque.

Le typosquattage peut lui aussi prêter à interprétation si le nom ressemble à celui d'une marque peu connue ou si la ressemblance est contestable.

Alors que faire pour déposer un domaine qui ne puisse être contesté? Des suggestions:

- Utiliser son nom propre.

- Utiliser un nom commun et non déposé comme marque.

- Prendre un atlas et reprendre le nom d'un lieu géographique hors de son pays et avec une extension en gTLD, ils ne peuvent être revendiqués comme noms de marque.

Rétrospective sur les pénalités du PageRank

C'était il y a déjà un an et plus, des sites parmi les plus connus voyaient leur PageRank affiché passer de 7 à 4 et l'on pensait à une sanction provisoire de la part de Google.

Mais on doit bien constater qu'il n'en est rien: 16 mois plus tard, ces pénalités sont toujours en place.

Elles n'ont pas vraiment d'influence sur le trafic, mais sont destinées à dissuader les webmasters d'utiliser leur PR comme monnaie d'échange pour la fourniture de backlinks payants ou comme base pour des échanges de liens.

Cela concernait des noms très connus:

- forbes.com PR 7 -> PR 5

- washingtonpost.com PR 7 -> PR 4

- engadget.com PR 7 -> PR 4

- autoblog.com PR 6 -> PR 4

On aurait pu penser que les professionnels du référencement étaient à l'abri d'une telle mésaventure. C'est tout le contraire en fait, c'est dans ce domaine que la plus grande proportion de sites ont été touchés:

- searchenginejournal.com PR 7 -> PR 4

- seroundtable.com PR 7 -> PR 4

- webrankinfo.com PR 7 -> PR 4

Un site Web (kinderstart.com) avait fait un procès à Google, et avait été débouté. Cependant, on peut vérifier que quelques uns des sites pénalisés ont retrouvé leur PR affiché:

- engadget.com affiche un PR 8 en progression.

- autoblog.com affiche un PR 7 en progression aussi.

On doit conclure que certains sites ont su revenir à une politique de liens naturels et d'autres non, mais puisque cela n'affecte pas leur trafic et que la barre verte du PR affiché (et logiquement transmis) est totalement ignorée du grand public, cela leur est sans doute totalement indifférent.

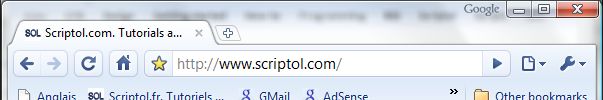

Chromemania

Safari 4 s'inspire de Chrome et ce sera, on le verra les années suivant, le début d'une tendance. La dernière version de Safari est extrêmement rapide. JavaScript s'exécute 42 fois plus vite que sous Internet Explorer 7 et 3,5 fois plus vite que sous Firefox 3 selon les tests de CNET. Et l'affichage d'une page est 3 fois plus rapide.

Et quand on regarde le nouvel aspect du Navigateur d'Apple, on constate une ressemblance certaine avec celui de Google.

Les onglets sont en haut de page et incorporent chacun une barre de navigation, et l'interface est épurée et simplifiée.

Safari 4 :

Chrome :

Les boutons sont similaires à l'exception du bouton de rechargement placé dans le champ d'URL comme sur Internet Explorer. La principale différence est que le champ de recherche est séparé dans Safari.

Safari se veut clairement un navigateur pour les applications Web 2.0.

Pourquoi meurent les digg-like?

Dans un mail envoyés aux habitués, les webmasters donnent généralement les motifs suivants:

- Twitter et Facebook leur font de l'ombre.

- Le service coûte cher en hébergement.

- On n'a plus assez de temps à lui consacrer.

On doit constater que quelques "followings" (suivis) sur Twitter bien choisis permettent d'accéder à des articles d'un réel interêt et qui plus est dans un domaine bien délimité... Il n'est pas étonnant que les internautes désoeuvrés passent maintenant plus de temps sur ces sites que sur les digg-likes un peu trop spammés.

La troisième raison en cache une autre beaucoup plus évidente: le site n'a plus d'audience. Dans ce cas pourquoi continuer à lui consacrer son temps évidemment.

Un site contributif requiert un travail de modération important, si on se relâche on entre dans une spirale négative où le contenu perd son intérêt et donc son audience et le webmaster perdra en conséquence le sien.

Quand à la seconde raison, elle est très relative. Un site fait entièrement par les autres ne coûte pas grand chose, mais s'il ne rapporte plus rien, il sera toujours trop cher à héberger.

La perte d'audience semble surtout venir de la perte de qualité dûe au spam, les groupes de blogueurs votant pour leurs billets respectifs à partir de Twitter, de façon systématique et même s'ils n'ont aucun contenu significatif. Dans ce cas autant rester sur Twitter ou aller sur Facebook, c'est un fait.

Scoopeo a été racheté, le site continue donc son activité et c'est le digg-like pioche.fr (qui le surpassait pourtant en trafic) qui à fermé ses portes. Suivi par Bluegger, Nuouz, Blogmemes, et tant d'autres.

Si l'idée vous venait de créer un site de ce genre, je suggèrerai avant de lire l'article: Comment faire un site original, pour trouver de meilleures idées!

L'algorithme du PageRank utilisé pour l'écosystème

Des chercheurs de l'université de Chicago ont eu l'idée d'adapter l'algorithme du PageRank aux interactions dans la nature afin de prédire les dysfonctionnements dans l'écosystème.

La nature, si l'on inclut la faune et la flore, est une vaste toile ou les uns mangent les autres, donc dépendent plus ou moins fortement de l'existence d'une autre espèce animale ou végétale.

La dépendance d'une espèce, par exemple des Panda envers le bambou, équivaut à des liens des seconds vers les premiers. La nourriture est le lien entre les espèces. Les pandas sont très populaires auprès des bambous comme un site est populaire auprès d'autres sites et obtient beaucoup de liens de leur part.

Supprimons le site populaire et tous les sites recevant des liens de sa part perdent leur positionnement et donc leur trafic.

Les chercheurs n'ont eu besoin que de modifications mineures à l'algorithme pour l'adapter, cependant le principe en a été inversé.

Sur le Web, une page est importante si de nombreuses pages pointent sur elle. Dans la nature, inversement, une espèce est importante si elle pointe vers des espèces importantes. Dans notre exemple, le bambous ont de nombreux liens vers les pandas.

Le réseau d'alimentation est cependant très complexe. La mort d'une créature, note le chercheur, apporte son corps au compost qui en nourrit d'autres.

En comparant l'algorithme du PageRank ainsi adapté à la nature, et d'autres procédés de calculs déjà employé dans le domaine, beaucoup plus difficiles à mettre en oeuvre, les chercheurs ont constaté qu'ils donnaient les mêmes résultats.

Le PageRank devrait permettre d'aider à sauver les espèces en voie de disparition, par une meilleure connaissance de l'écosystème et une plus grande capacité de prévision.

Référence: PLoS Computational Biology. Dr Stefano Allesina et Dr Mercedes Pascual.

Les sites Web les plus fréquentés en 2009

En utilisant AdPlanner, on peut obtenir le classement des sites français les plus consultés par les internautes. La liste se trouve ci-dessous... Elle ne comprend pas les sites internationaux comme Microsoft ni les fournisseurs d'accès ou moteurs de recherche.

Le chiffre à droite est le nombre de visiteurs uniques par jour, en millions.

Le top des sites français

Sites collaboratifs et d'échange

| Skyrock.com | Hébergement de blogs. | 9 M |

| Dailymotion.com | Partage de vidéos | 7,4 |

| Réseau social. | 7,3 | |

| Over-blog.com | Hébergement de blogs. | 4,2 |

| Deezer.com | Partage musical. | 3,5 |

| Wordpress.com | Hébergement de blogs. | 1,5 |

Vie pratique et santé

| ebay.fr | Vente aux enchères. | 8,1 |

| Pagesjaunes.fr | Annuaire téléphonique. | 7,5 |

| Priceminister.fr | Comparateur. | 5,1 |

| Allocine.fr | Cinéma. | 4,6 |

| Aufeminin.com | Magazine. | 3,4 |

| Leboncoin.fr | Guide. | 4,6 |

| Doctissimo.fr | Santé. | 4,6 |

| Meteofrance.com | Météorologie. | 2,8 |

| Programme-tv.net | Télévision. | 2,6 |

| Viamichelin.com | Cartes routières. | 1,9 |

| Kijiji.fr | Petites annonces. | 1,5 |

| Seloger.com | Annonces immobilières. | 1,1 |

Presse et actualité

| 01net | 5,1 |

| Lemonde.fr | 2,6 |

| Infos-du-net.fr | 2,6 |

| Lequipe.fr | 2,6 |

| Le Figaro | 1,8 |

| Nouvelobs.com | 1,5 |

Techniques

| Commentcamarche.com | 8,2 |

| Linternaute.com | 7,5 |

| Clubic.com | 3,5 |

| jeuxvideo.com | 2,9 |

| hardware.fr | 1,8 |

Vente par correspondance

| Laredoute.fr | 3,1 |

| Ciao.fr | 2,6 |

| Rueducommerce.Fr | 2 |

Les perdants

Les sites Alapage.com et Clust.com, filiales de France Télécom, 170 salariés, sont fermé en mars. Topachat.com une autre filiale a été revendue (à rueducommerce.com). Clust.com a un trafic insignifiant, mais Alapage occupe la position 4800 selon Alexa. On croit rêver.

D'autres grands noms du Web ont disparu. Lycos a revendu Caramail et fermé Jubii.